Human-In-The-Loop

Der Schlüssel zu leistungsstarker KI in komplexen Szenarien

Oft stellen wir uns die Frage: Wie viel Autonomie ist bei KI eigentlich sinnvoll? Und wo ist es besser, Menschen einzubinden? KI-Agenten können heute schon eine Menge. Sie treffen Entscheidungen, agieren mit anderen Systemen und sind in der Lage, ganze Prozesse abzuwickeln. Aber ist das immer das Ziel?

Aus unserer Sicht nicht. Gerade in Projekten, in denen Entscheidungen Tragweite haben oder viel Domänenwissen gefragt ist, kann ein vollautomatisierter Ansatz schnell zum Risiko werden. Bei BCxP setzen wir deshalb auf den Ansatz, nicht möglichst viel, sondern genau das Richtige zu automatisieren. In den meisten Fällen resultieren daraus: Nutzergeführte KI-Agenten, sogenannte Human-In-The-Loop-Systeme.

KI-Agenten, die mitdenken: Was steckt dahinter?

Aber erst mal ganz allgemein: Was sind überhaupt KI-Agenten und welche Möglichkeiten eröffnen sie? KI-Agenten sind erweiterte Chatbots, die selbstständig Entscheidungen treffen, Aktionen ausführen und somit auch komplexe Abläufe steuern können.

Beispiel: Ein einfacher LLM-basierter Chatbot beantwortet die Frage nach dem Wetter aus statischen Modelldaten, welche im Sprachmodell gespeichert sind. Ein KI-Agent hingegen erkennt, dass aktuelle Informationen nötig sind, ruft selbstständig eine Wetter-API auf und liefert die Echtzeitprognose.

Heute schon können solche Agenten Aufgaben vom Produktkauf bis zur Prozessoptimierung übernehmen. Doch bei Entscheidungen mit großer Tragweite steigt das Risiko: Eine falsche Kalenderinformation kann zu einer fehlerhaften Reisebuchung führen, ein industrieller Agent könnte die Produktion hochfahren und Lager- oder Liefergrenzen übersehen.

Der Teufel steckt oft im Detail. Einen Agenten auf alle Eventualitäten vorzubereiten, macht KI-Systeme schnell unnötig komplex und unzuverlässig. Daher setzen wir auf Nutzerführung: Routineaufgaben automatisieren, bei kritischen Entscheidungen den Menschen einbeziehen.

Grenzen der Autonomie: Erfahrungen aus der Praxis

Die Idee, nutzergeführte KI-Agenten zu entwickeln, entstand bei uns nicht aus theoretischen Überlegungen, sondern aus konkreten Praxiserfahrungen. Immer wieder stießen wir auf Anforderungen, die den reinen Automatisierungsansatz in Frage stellten und zeigten: Vollautonome Systeme geraten in bestimmten Szenarien schnell an ihre Grenzen.

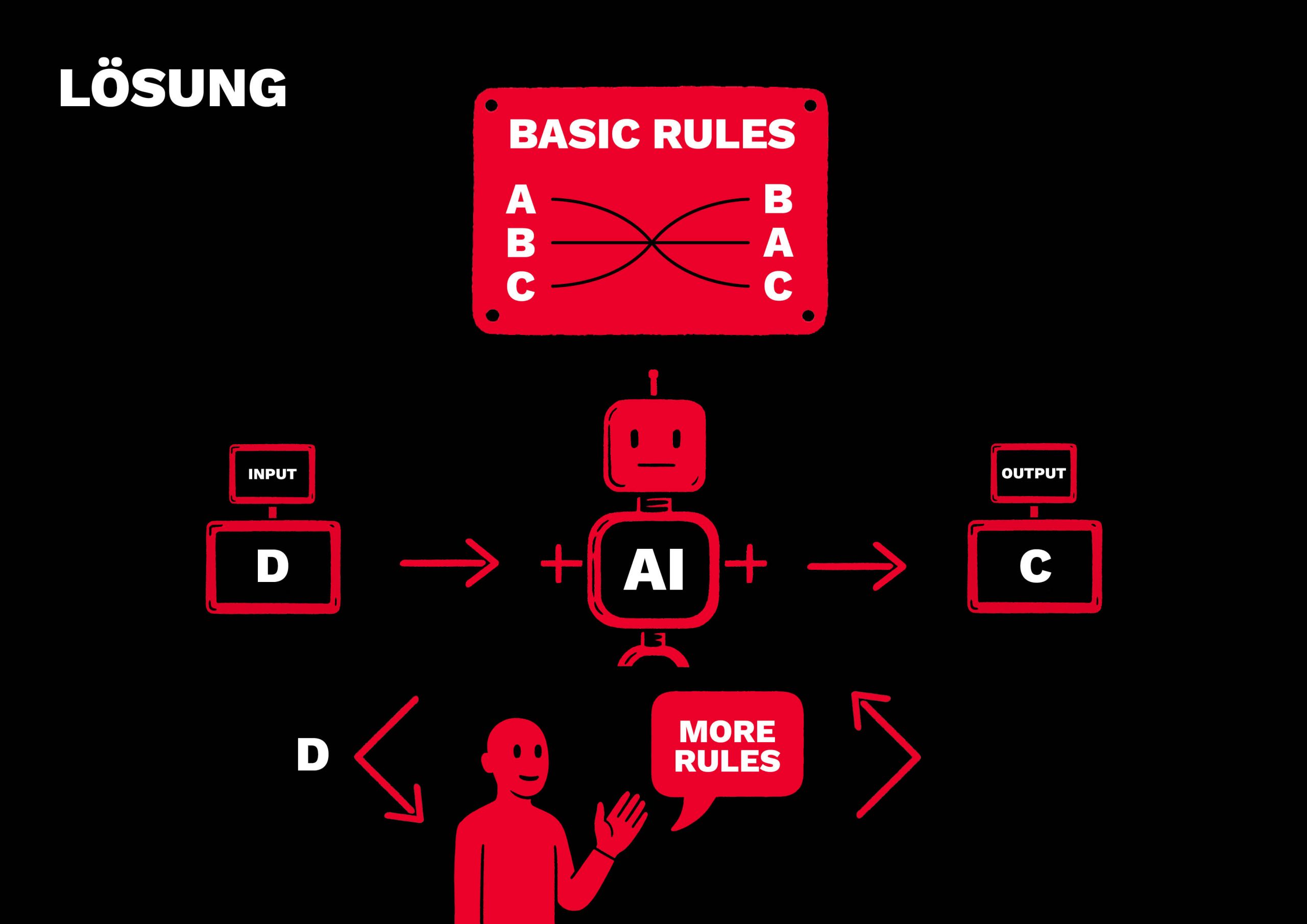

Ein Beispiel ist die Entwicklung eines firmeninternen Buchungstools für Arbeitszeiten. Bei Anfragen wie „Buche mir 2 Stunden für die Tätigkeit ‚Hackathon Stundenzettel Chatbot‚“ fand der Agent richtigerweise mehrere passende Konten etwa „Innovationszeit“ oder „KI-Community“. Welches gemeint war, hing vom spezifischen Kontext ab, den nur Mitarbeitende kannte. Ohne Rückfrage wäre die Entscheidung, auf welches Konto gebucht werden soll, spekulativ gewesen. Solche Fälle mit unterspezifiziertem Input lösen wir, indem der Agent der:dem Nutzenden seine Auswahl an Konten präsentiert, welche:r dann die finale Auswahl trifft und die Buchung letztlich bestätigt.

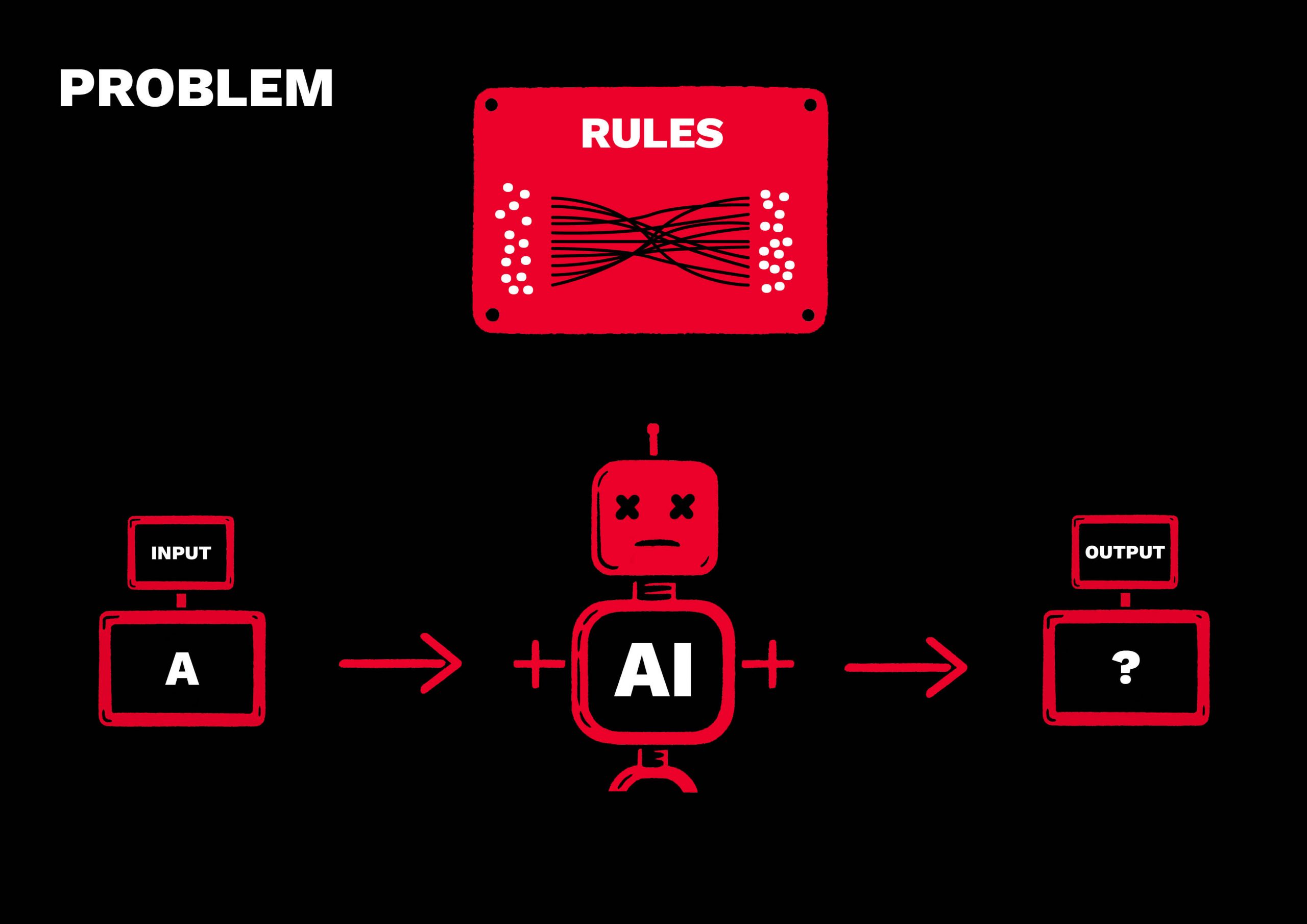

Ein weiteres Beispiel ist ein sprachbasierter Produktkonfigurator für Autos. Komplexe Eingaben wie „Modell X500 in luxuriöser Ausstattung mit Anhängerkupplung“ sollten auf konkrete Konfigurationen abgebildet werden. Mit wachsender Menge an Auswahlmöglichkeiten und komplexem Regelwerk mit Sonderregeln und Ausnahmefällen stiegen die Fehler. Daher verwendeten wir auch hier einen Human-In-The-Loop-Ansatz: Der Agent filtert passende Konfigurationen basierend auf einem reduzierten Regelwerk vor, der:die Nutzer:in überprüft das Ergebnis und trifft eine finale Auswahl.

Neben unseren eigenen Erfahrungen belegen auch aktuelle Forschungsergebnisse, dass Large Language Models (LLMs) weiterhin Schwierigkeiten damit haben, im Prompt spezifizierte Regeln korrekt auf Eingaben anzuwenden – nicht nur bei komplexen Regelwerken, sondern auch, wenn Regeln kombiniert werden müssen.1 2

Für uns führt das zu einer klaren Erkenntnis: In Szenarien mit hoher Komplexität, Regelvielfalt oder potenzieller Mehrdeutigkeit ist Nutzerführung eine notwendige Voraussetzung für ein zuverlässiges Systemverhalten. Ein Human-In-The-Loop-Ansatz ermöglicht es hierbei, die Stärken der KI gezielt auszuschöpfen, ohne die Kontrolle über kritische Entscheidungen aus der Hand zu geben. Dabei wird nicht nur die Zuverlässigkeit des Systems erhöht. Auch der Aufwand für die Entwicklung eines KI-Systems wird deutlich reduziert, da komplexe Fälle dem Menschen überlassen werden und nicht mittels aufwendigem Prompt-Engineering gelöst werden müssen.

Mensch und Maschine: Zum Ziel mit Nutzerführung

Bei der Automatisierung von Entscheidungen in Prozessen unterscheiden wir grundsätzlich drei Ansätze:

- Geführte Entscheidung: Der:Die Nutzende entscheidet bei jedem Schritt aktiv mit. Ein Beispiel ist die finale Auswahl aus mehreren vom Agenten vorgeschlagenen Optionen. Geführte Entscheidungen sind vor allem an äußerst kritischen Stellen zu empfehlen.

- Teilweise geführte Entscheidung: Der Agent trifft Entscheidungen selbst, wenn es eine eindeutige und mit hoher Wahrscheinlichkeit korrekte Option gibt. Bei Unsicherheiten fragt er gezielt beim:bei Nutzenden nach. Somit wird das Risiko für Fehler minimiert bei gleichzeitiger Maximierung des Automatisierungsgrades.

- Autonome Entscheidung: Der Agent handelt vollständig autonom, wenn die Aufgaben klar umrissen und unkritisch sind.

Unsere Erfahrungen mit nutzergeführten KI-Agenten zeigen deutlich, dass der beste Weg nicht darin besteht, alles blind zu automatisieren und die Entscheidungsgewalt vollständig abzugeben. Besonders bei komplexen Aufgaben oder wissensintensiven Entscheidungen bleibt der Mensch unverzichtbar, mit seinem Kontext- und Fachwissen, seinem Urteilsvermögen und seinem Gespür für Nuancen.

Nutzergeführte KI-Agenten kombinieren die Stärken von Mensch und Maschine. Sie übernehmen zeitraubende Routineaufgaben, beschleunigen Prozesse und sorgen gleichzeitig dafür, dass kritische Entscheidungen unter menschlicher Kontrolle bleiben. Das reduziert Fehler, erhöht die Transparenz und stärkt das Vertrauen in die Technologie.

Wir sind überzeugt, dass nutzergeführte KI-Agenten nicht nur ein Schlüssel für verantwortungsvolle und erfolgreiche KI-Anwendungen in der Zukunft sind, sondern bereits heute messbaren Mehrwert in der Praxis liefern.

Fragen? Ideen? Oder ein Prozess, bei dem ihr euch nutzergeführte KI-Agenten vorstellen könnt?

Paul freut sich darauf, mit euch gemeinsam herauszufinden, wie nutzergeführte KI echten Mehrwert in eurem Unternehmen schaffen kann. Ob ihr gerade erste Gedanken zur KI-Nutzung habt oder schon einen konkreten Use Case im Blick – Paul bringt technisches Know-how, Branchenverständnis und Erfahrung mit, um mit euch die perfekte Balance zwischen Automatisierung und menschlicher Steuerung zu finden.

Lasst uns gemeinsam das volle Potenzial von KI nutzen – mit einem Ansatz, der Effizienz und Kontrolle garantiert.

Neugierig geworden? Paul freut sich auf eure Nachricht!

- Frontier LLMs Still Struggle with Simple Reasoning Tasks (Malek et al. , arXiv, 2025) ↩︎

- RuleArena: A Benchmark for Rule-Guided Reasoning with LLMs in Real-World Scenarios (Zhou et al., ACL 2025) ↩︎

Hinweis: Das Header- und Zusatzbild dieses Artikels wurden mithilfe Künstlicher Intelligenz erstellt.